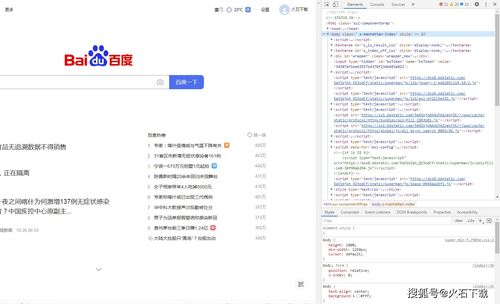

随着互联网时代的不断发展,爬虫采集已经成为了目前最为主流的数据获取方式。使用爬虫软件自动从网站中提取数据可以节省大量的时间和精力。

但是,如果网站所有者发现了用户的真实IP地址,往往就会直接选择进行限制。

接下来就一起来看看爬虫抓取网络数据时经常遇到的六种问题吧:1.IP阻止IP阻止是指网站所有者主动阻止用户的IP地址访问其网站。这可能由于多种原因而发生,但最常见的做法是防止网页抓取。2.HTTP错误HTTP错误是用户尝试访问网站时发生的错误。

它们可能是由许多原因引起的,包括在抓取脚本中没有考虑到的IP块和网站更改。

3.验证码验证码是来访用户必须回答以证明人类身份的图像或问题。网站使用它们来保护自己免受自动机器人的侵害。4.超时超时是指托管用户尝试抓取的网站的服务器在一定时间内没有响应。

这可能是由IP块、网站更改或只是连接缓慢引起的。5.蜜罐陷阱蜜罐陷阱是网站用来识别和跟踪爬虫的一种机制。

他们通过在其页面上包含仅对抓取工具可见的隐藏数据或元素来做到这一点。

如果爬虫提取了这些数据,网站所有者就知道它是机器人而不是人类,并可以采取适当的行动。6.登录要求一些网站还具有旨在防止网页抓取的登录要求。他们可能会要求用户在继续数据提取过程之前在他们的网站上注册。

或者,他们可能会直接发送一封电子邮件,其中包含一个链接,记录用户的IP地址并将其标识为爬虫。